El doctor José Lucio, profesor e investigador de la Escuela Politécnica Nacional, es quien dirije la investigación de este proyecto. Foto: EL COMERCIO

La ubicación espacial de los seres humanos se basa en la fusión de varios elementos captados por nuestros sentidos, principalmente imágenes y sonidos. Pero ¿qué pasa si no podemos captar aquello? Es el problema al que diariamente se enfrentan las personas que tienen discapacidad visual.

Al echar en falta las imágenes, otros sentidos como el del oído o del tacto deben ser utilizados en mayor intensidad para poder producir imágenes mentales del entorno espacial. Actualmente, la Escuela Politécnica Nacional está desarrollando un sistema de ubicación acústica mediante el uso de sonido 3D.

José Lucio, profesor e investigador de esta universidad, define el sonido 3D como una señal acústica que permite a una persona, que escucha un audio, recrear la sensación de inmersión acústica en un ambiente. Lucio es el director del proyecto, y se ha encargado de la simulación y modelado computacional. La idea es crear un mapa sonoro del ambiente que permita a las personas con discapacidad visual ubicar incluso objetos que naturalmente no producen un sonido.

Esta investigación es desarrollada tanto por las facultades de Ingeniería Electrónica y de Ingeniería de Sistemas (FIS). La primera se ha encargado de la creación de un sistema de hardware que está en capacidad de captar las imágenes, mientras que la segunda desarrolla el software que interpretará esas imágenes.

Diego Navas, colaborador del proyecto, manipula los sensores de proximidad. Foto: EL COMERCIO

En lo que respecta al hardware, el responsable del proyecto es Luis Alberto Morales, catedrático de la Politécnica. Aquí se han explorado dos alternativas. La primera es el uso de un sistema de emisión láser que pueda hacer un barrido del entorno para detectar la ubicación espacial de los objetos.

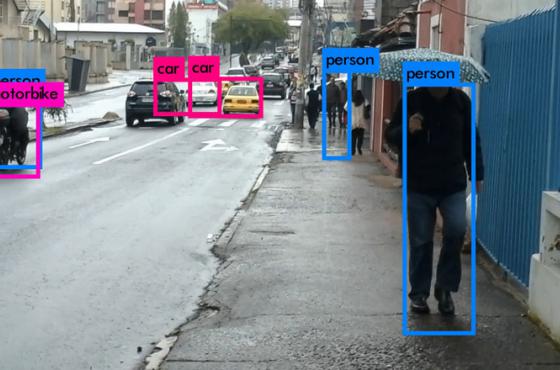

La segunda consiste en dos cámaras estereoscópicas, que funcionarían de forma similar a la que lo hacen los ojos, para captar la imagen y ubicación de los objetos. Henry Paz, docente de la universidad, también es parte del proyecto, y se ha encargado del desarrollo de la visión computacional y las redes neuronales que identifican de objetos.

“La visión computacional aplica técnicas de ‘machine learning’ para identificar y etiquetar obstáculos (personas, autos o escaleras) hasta a 20 metros de distancia”, indica Paz. En cuanto al software, la FIS ha desarrollado un ‘motor de aurilización’, que es el encargado de dotar de una localización por medio de sistemas auditivos.

El motor de aurilización permite ubicar imágenes en el mundo real y transformarlas en un equivalente sonoro, para luego reproducir un sonido en su ubicación. Foto: EL COMERCIO

Mediante el uso de este motor, los objetos captados por el sistema de hardware son transformados en sonido envolvente en 3D. Luego, son devueltos al sistema y transmitidos a unos audífonos para entregar al usuario la ubicación de un objeto y su posición.

Este proyecto está terminando la fase inicial de investigación e implementación, para poder fusionar los componentes de hardware en un solo dispositivo, que podría ser un chaleco o unas gafas y un cinturón. Para el futuro, este proyecto podrá buscar financiamiento de la empresa privada.

Fuente: El Comercio